OpenAI在研究文本到三維對象方面取得了快速進展。已經托管至GitHub的Shap-E據稱可以直接從文本描述中生成3D asset,或者從提供的圖像中構建相關內容。

如果大家有印象,OpenAI早在2022年12月就發布了能夠根據文本提示建立點云形式的基本3D模型的Point-E系統。

現在,團隊又發布了速度大大增加的全新系統Shap-E。其中,它能夠以 “隱式函數 “的形式建立模型,既可以呈現為紋理網格,又可以呈現為神經輻射場(NeRFs),即使用機器學習從二維圖像中開發的三維模型。團隊指出,盡管質量不及其他優化模型,但Shap-E的速度要快幾個數量級,從而為用戶提供了有利的權衡。

近來生成式圖像模型的爆炸性增長,所以社區對訓練其他類似模型的興趣越來越大,如音頻、視頻和3D asset。大多數都適合于可以直接生成的自然的、固定大小的張量表示,例如圖像的像素網格或音頻的樣本陣列。然而,如何以一種高效生成并易于在下游應用中實現的方式來表示3D asset是一個問題。

最近,隱性神經表征(INRs)已成為流行的3D asset編碼方式。為了表示三維資產,INRs通常將3D坐標映射到特定的位置信息,如密度和顏色。一般來說,INRs獨立于分辨率,因為它們可以在任意的輸入點進行查詢,而不是在一個固定的網格或序列中進行信息編碼。由于它們是端到端的可微分,INRs能夠實現各種下游應用,例如可微分的形狀編輯。

在研究中,OpenAI專注于兩種類型的INRs的3D表示:神經輻射場(NeRF)是一種INR,它將3D場景表示為一個將坐標和觀察方向映射到密度和RGB顏色的函數。NeRF可以通過查詢密度和沿camera光線的顏色,從任意視圖中渲染出來,并進行訓練以匹配3D場景的ground truth渲染。 DMTet和它的擴展GET3D將一個有紋理的三維網格表示為一個將坐標映射到顏色、符號距離和頂點偏移的函數。這個INR能夠以可微分的方式構建3D三角形網格,而所得到的網格可以使用可微分光柵化庫進行高效渲染。

盡管INR靈活和富有表現力,但為數據集中的每個樣本獲取INR的過程成本可能十分高昂。另外,每個INR可能存在諸多數字參數,在訓練下游生成模型時可能會帶來挑戰。

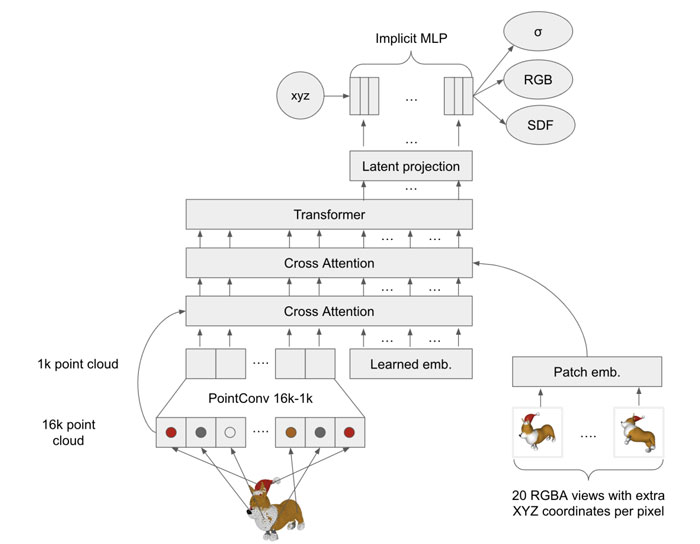

針對所述問題,社區有嘗試使用帶有隱式解碼器的自動編碼器來獲得較小的latent表征,從而直接用現有的生成技術進行建模。另外,有人使用元學習來創建一個共享大部分參數的INRs數據集,然后在自由參數訓練擴散模型或歸一化流。其他人則進一步建議,基于梯度的元學習根本沒有必要,而是可以直接訓練一個Transformer編碼器來產生以3D對象的多個視圖為條件的NeRF參數。

OpenAI結合并擴大了上述幾種方法,并最終得出了Shap-E。

這是一個適用于各種復雜的3D latent表征的條件生成模型。首先,團隊通過訓練一個基于Transformer的編碼器來產生3D asset的INR參數。接下來,在編碼器的輸出上訓練一個擴散模型。

與以前的方法不同,產生的INR同時代表NeRFs和網格,允許它們以多種方式渲染或導入下游的3D應用程序。

Shap-E

在對數百萬個3D asset的數據集進行訓練時,模型能夠在文本提示的條件下產生多樣化的、可識別的樣本,如上圖所示。

Point-E

與早前提出的顯式3D生成式模型Point-E相比,這個模型收斂得更快,并且在共享相同的模型結構、數據集和調節機制的情況下,它可以獲得可比或更高的結果。令人驚訝的是,Shap-E和Point-E在以圖像為條件時傾向于出現相同成功和失敗的案例,這表明對輸出表示的非常不同選擇依然可以導致類似的模型行為。

然而,研究人員同時觀察到這兩個模型之間的質量差異,特別是當直接以文字說明為條件時。像Point-E一樣,Shap-E的樣本質量依然比基于優化的文本條件的3D生成式方法要差。然而,它在推理時間上比所述方法快了幾個數量級,允許一個潛在的有利權衡。

例如,對于質量要求不高的場景元素,用戶可以通過Shap-E快速生成相關的3D asset,而對于其他元素,用戶則可以使用質量更多的3D生成式方式,從而快速高效地完成場景創建。

產品與服務

產品與服務

聯系站長

聯系站長

關于我們

關于我們